Der Termin entfällt und wird voraussichtlich im Sommersemester 2024 nachgeholt.

Do 01.02., 14-16 Uhr, Grimm-Zentrum, Auditorium

Topic Modeling ist eine in den digitalen Geistes- und Geschichtswissenschaften etablierte Methode zur Exploration und quantitativen Analyse umfangreicher Textkorpora. Sie ermöglicht die automatisierte Identifikation gemeinsamer Sprachgebrauchsmuster, die wie Themen, Motive oder Diskurse interpretiert werden können. Allerdings gehen mit Topic Modeling auch einige methodologische und epistemologische Herausforderungen einher. Vor diesem Hintergrund wird der Vortrag aus geschichtswissenschaftlicher und methodenkritischer Perspektive die Potenziale und Grenzen von Topic Modeling diskutieren und einen Workflow vorschlagen. Dazu wird einerseits in die Grundprinzipien der Methode eingeführt und die Entwicklungsgeschichte skizziert sowie andererseits ein Überblick über den aktuellen Entwicklungsstand gegeben. Betont wird zudem die Relevanz des Preprocessings der Textdaten sowie die kritische Beurteilung der Modellierungsergebnisse.

Melanie Althage ist wissenschaftliche Mitarbeiterin an der Professur für Digital History (Institut für Geschichtswissenschaften, Humboldt-Universität zu Berlin). In ihrem Dissertationsprojekt widmet sie sich der methodenkritischen Untersuchung der Adaptierbarkeit etablierter Textanalysemethoden der Digital Humanities und Computerwissenschaften für historische Quellen und Forschungsfragen am Beispiel der digitalen historischen Fachkommunikation. Ziel ist dabei die Etablierung einer Methodenkritik als Erweiterung der historisch-kritischen Methode der Geschichtswissenschaften.

Der Vortrag ist Teil der Reihe „Werkzeug. Zur Praxis computergestützter Forschung in den Geistes- und Kulturwissenschaften“.

Do 18.01., 14-16 Uhr, Grimm-Zentrum, Auditorium

Zitate sind ein wichtiges Indiz für intertextuelle Verhältnisse. Insbesondere direkte, wörtliche Übernahmen weisen auf Stellen hin, die so bedeutend sind, dass sie nicht in ‘eigenen Worten’ wiedergegeben werden können oder durch eigene Worte ersetzt werden sollen. In unseren Projekten zur Identifikation von “Schlüsselstellen” sowie zur (Nach-)Nutzung vorhandenen Expert*innenwissens in den Computational Literary Studies haben wir Verfahren zur Text-Reuse-Detection entwickelt, die sich insbesondere auf die bislang systematisch ungeklärte Beziehung von Quellen und wissenschaftlichen Texten konzentrieren, aber auch andere Formen von Intertextualität erfassen.

Steffen Martus ist Professor für Neuere deutsche Literatur am Institut für deutsche Literatur der Humboldt–Universität zu Berlin. Seine Forschungsschwerpunkte liegen in der Literaturgeschichte vom 18. Jahrhundert bis zur Gegenwart, in der Literaturtheorie (insbesondere Theorien des literarischen Werks) sowie der Wissenschaftstheorie und -geschichte der Geisteswissenschaften. Im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies leitet er gemeinsam mit Rober Jäschke ein Projekt zu Schlüsselstellen in der Literatur (2020-2026). Gemeinsam mit Jörn Kreutel (Berliner Hochschule für Technik) leitet er das DFG-Projekt „Forschungsplattform Literarisches Feld DDR: Autor*innen, Werke, Netzwerke“.

Robert Jäschke ist Professor für Information Processing and Analytics am Institut für Bibliotheks- und Informationswissenschaft der Humboldt-Universität zu Berlin. Sein Forschungsschwerpunkt sind Verfahren (vorrangig des maschinellen Lernens) zur Verarbeitung und Analyse großer Datenmengen. Beispielsweise erforscht er im DFG-Projekt Unknown Data (2022-2025) Verfahren zum Finden und Katalogisieren von Long-Tail-Forschungsdaten der Informatik und der Sozialwissenschaften. Im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies leitet er gemeinsam mit Steffen Martus ein Projekt zu Schlüsselstellen in der Literatur (2020-2026). Robert Jäschke ist Mitbegründer des Social-Bookmarking-Dienstes BibSonomy und Gründer und Mitherausgeber des Blogs weltliteratur.net, einem „Schwarzmarkt für die Digitalen Geisteswissenschaften“.

Frederik Arnold ist akademischer Mitarbeiter am Lehrstuhl für Information Processing and Analytics am Institut für Bibliotheks- und Informationswissenschaft. Er forscht im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies zu Schlüsselstellen in der Literatur mit Fokus auf der automatisierten Entdeckung. Er hat seinen Master in Computerlinguistik an der Universität des Saarlandes erworben.

Der Vortrag ist Teil unserer „Werkzeug“-Reihe. Infos zur Reihe: https://hu.berlin/werkzeug.

Do 15.02., 14-16 Uhr, Grimm-Zentrum, Auditorium

Texterkennung (Optical Character Recognition, OCR) ist die Technologie um aus Scans (also Bildern) von Dokumenten digitale, editierbare und durchsuchbare Volltexte zu erzeugen. Sowohl durch Digital Humanities als auch Künstliche Intelligenz steigt der Bedarf von Wissenschaft und Forschung an digitalen Texten. Jedoch ist die Texterkennung, insbesondere für historische Dokumente, noch stets eine sowohl technisch als auch organisatorisch hoch komplexe Aufgabe. Der Vortrag hat daher zum Ziel die Grundlagen, technischen Verfahren und den aktuellen Stand der Entwicklungen im Bereich der OCR vorzustellen um so einen gründlichen Überblick über die Möglichkeiten und Herausforderungen zu geben. Dabei werden neben Ursprung und Geschichte der OCR insbesondere die vielfältigen Verarbeitungsschritte in einem typischen OCR-Workflow, die besonderen Anforderungen von historischem Material sowie aktuelle Forschungsprojekte und technologische Entwicklungen im Zentrum stehen.

Clemens Neudecker arbeitet als Forscher, Projektmanager und Library Hacker an der Staatsbibliothek zu Berlin. Er ist dort unter anderem eingebunden in das umfangreiche Verbundprojekt OCR-D. Seine Arbeitsschwerpunkte sind Computer Vision, Natural Language Processing, Machine Learning & Artificial Intelligence und ihr Einsatz in den Bereichen Digitale Bibliotheken und Digital Humanities.

Der Vortrag ist Teil unserer „Werkzeug“-Reihe. Infos zur Reihe: https://hu.berlin/werkzeug.

Mi 20.12., 14-16 Uhr, Grimm-Zentrum, Auditorium

Vortrag und Gespräch auf englisch.

This talk is about the science of visualizing networks. Although the field of graph drawing, as we call it, has no shortage of theoretical contributions, those have always followed practices; and with a sensible delay. Mathieu Jacomy, co-founder of the network visualization tool Gephi, will sketch the double story of the craftsmanship and the academic evaluation of representing networks as dots and lines, from Jacob Moreno’s sociograms, to Peter Eades‘ first force-driven layout algorithms, to Helen Purchase’s aesthetic criteria, and finally to the data deluge and the availability of large complex networks, paving the way to network science. This story will show how practices shape cultures in ways that escape the control of academics, at once bad and good, uninformed yet innovative, unjustified yet meaningful. Reading a large complex network is not the same as a small diagram, and the talk will provide illustrations of the ideas that had to be left behind to properly frame graph drawing as a mediation driven by technology. Which will also help you read large network maps properly.

Mathieu Jacomy is Doctor of Techno-Anthropology and assistant professor at the Aalborg University Tantlab, and MASSHINE center. He was a research engineer for 10 years at the Sciences Po médialab in Paris, and is a co-founder of Gephi, a popular network visualization tool. He develops digital instruments involving data visualization and network analysis for the social science and humanities. His current research focuses on visual network analysis, digital controversy mapping, and computational social science. He toots at @jacomyma@mas.to and blogs at reticular.hypotheses.org.

Der Vortrag ist Teil der Reihe „Werkzeug. Zur Praxis computergestützter Forschung in den Geistes- und Kulturwissenschaften“. Weitere Termine der Reihe: https://hu.berlin/werkzeug.

Bild oben: Netzwerk mit 1000 Knoten und sichtbaren Clustern, mit Gephi erstellt. Martin Grandjean, CC BY-SA 4.0 https://creativecommons.org/licenses/by-sa/4.0, via Wikimedia Commons, https://commons.wikimedia.org/wiki/File:Social_Network_Visualization.png.

Termin: 26.01.2024, 9-15 Uhr

Ort: Humboldt-Universität, Hauptgebäude UdL 6

Anmeldung: bis 25.01.2024 per Email an ub.makerspace@hu-berlin.de

OCR (Optical Character Recognition) und HTR (Handwritten Text Recognition) stellen in den Geistes- und Kulturwissenschaften nach wie vor eine Herausforderung dar. OCR4all bietet allen Nutzer:innen eine frei verfügbare und einfach zu bedienende Möglichkeit, eigene OCR/HTR-Workflows durchzuführen. Dieser Workshop wird die allgemeinen Grundlagen und Konzepte von OCR vorstellen sowie in die Software OCR4all einführen.

Im Rahmen des Workshops wird weiterhin geklärt werden, welche Daten und Dateitypen für OCR erforderlich sind, wie sich je nach Ausgangsmaterial die Anwendung des in OCR4all integrierten OCR- bzw. HTR-Workflows verändert, mit welchem (manuellen) Aufwand zu rechnen ist und inwiefern sich der Workflow automatisieren lässt. Zusätzlich wird thematisiert, was Modelle sind, wie diese eigenständig trainiert werden können und welche Erkennungsgenauigkeiten zu erwarten sind.

Nach Abschluss des Workshops, werden alle Teilnehmer:innen in der Lage sein, selbstständig komplexe OCR/HTR-Projekte zu bearbeiten.

Arbeitsmaterial und Beispieltexte verschiedener Epochen und Zeichensystemen wird zur Verfügung gestellt. Für eine Teilnahme ist keinerlei Vorwissen notwendig.

Der Workshop wird durchgeführt vom Entwicklungs- und Support-Team von OCR4all in Zusammenarbeit mit der Kompetenzwerkstatt Digital Humanities.

Veranstaltungshinweis: Passend zum Workshop findet am 15.02.2024 im Rahmen unserer Werkzeug-Reihe ein Vortrag zum Thema OCR statt, der sich unter anderem mit einigen erkenntnispraktischen und -theoretischen Konsequenzen beschäftigt, die der Einsatz von OCR und die Arbeit mit OCR-Ergebnissen mit sich bringt. Der Vortrag geht auch auf die OCR-Technologien ein, die im Rahmen des Langzeitprojekts OCR-D entwickelt werden und die auch in der Software OCR4all Verwendung finden.

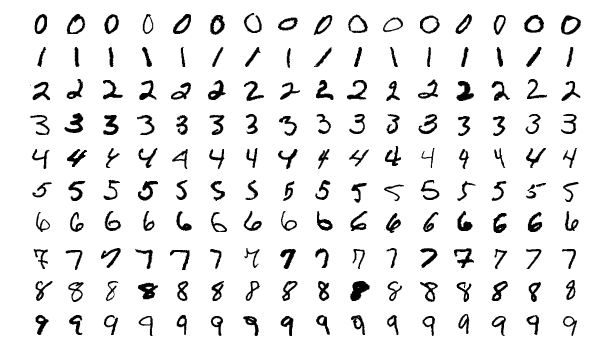

Das Bild oben zeigt Beispiele aus der MNIST-Datenbank, die fürs Training von OCR-Software verwendet wird. Bild: Josef Steppan, CC BY-SA 4.0 https://creativecommons.org/licenses/by-sa/4.0, via Wikimedia Commons (bearbeitet).

Datum: 6.12.2023, 14-16 Uhr

Ort: Grimm-Zentrum, Auditorium

Der Vortrag präsentiert die wichtigsten Ergebnissen meiner kürzlich an der Humboldt-Universität zu Berlin erschienenen Dissertation sowie die zu deren Erarbeitung angewandten Methoden.[1] Die Präsentation fokussiert auf den Einsatz verschiedener Werkzeuge aus dem Bereich des Natural Language Processing (NLP) sowie im weiteren Sinne der Digital Humanities (DH) zur Bearbeitung und heuristischen Beantwortung literatur- und editionswissenschaftlicher Fragestellungen. Analysiert wird ein etwa 3500 handschriftliche Seiten umfassendes Volltextkorpus zu Alexander von Humboldts sogenannten Kosmos-Vorträgen (Berlin, 1827/28).[2] Da Manuskripte des Vortragenden nicht vollständig und nicht in ihrer ursprünglichen Form überliefert sind, stellen die im Korpus enthaltenen Mitschriften, Nachschriften und deren Abschriften aus dem Kreis der Hörerinnen und Hörer die wichtigsten Quellen zu den Inhalten der Kosmos-Vorträge dar.

Editionstheoretische Überlegungen, wie mit diesem Quellenbestand in einer (Digitalen) Edition zu verfahren ist, leiten über zu exemplarischen Untersuchungen des Korpus. Dabei kommen neben ‚traditionell hermeneutischen‘ Methoden vor allem quantitative Untersuchungen und Verfahren wie automatische Kollation bzw. Plagiatssuche zum Einsatz. Es wird gezeigt, wie die eingesetzten NLP- bzw. DH-Werkzeuge helfen können, ein so umfangreiches Textkorpus zu strukturieren und für konzentrierte Lektüren zu erschließen, ohne dabei früheren – nicht nur aus heutiger Sicht inadäquaten – editorischen Ansätzen einer Reduzierung der Quellenvielfalt folgen zu müssen. Voraussetzungen zur Arbeit mit Editionen bzw. Korpora wie diesem sind einerseits die umfangreiche editionsseitige Dokumentation der Überlieferungssituation, der Quellenbasis und des Digitalisierungsprozesses, vor allem der möglichst generischen, zum Teil jedoch zwangsläufig projektspezifischen Richtlinien zur Transkription und Annotation der Volltexte sowie der Möglichkeiten zu deren Nachnutzung. Nutzer:innenseitig ist entsprechend ein höheres Maß an ‚Data & Tool Literacy‘ erforderlich, wobei gezeigt wird, wie selbst vergleichsweise einfache, anwendungsbereite Werkzeuge unter Einbezug basaler Annotationen in die Analyse effizient und zielführend eingesetzt werden können.

Eine der Leitfragen des Vortrags ist, inwieweit Humboldts berühmte Kosmos-Vorträge mit diesen Methoden und auf der Grundlage einer parallelen, gleichwertigen Digitalen Edition aller überlieferten Textzeugen rekonstruierbar sind – oder vielmehr: ob dies überhaupt ein sinnvolles und grundsätzlich erreichbares Ziel sein kann.[3] Inwiefern dies nicht der Fall ist und was dies für die Edition und Analyse von Quellen aus dieser und vielen anderen vergleichbaren Überlieferungssituationen bedeutet, ist die sehr viel interessantere zentrale Frage im Anschluss.

Christian Thomas ist Wissenschaftlicher Mitarbeiter im Akademienvorhaben „Alexander von Humboldt auf Reisen – Wissenschaft aus der Bewegung “ an der Berlin-Brandenburgischen Akademie der Wissenschaften sowie im Akademienvorhaben „Propyläen – Goethes Biographica “ an der Klassik Stiftung Weimar. Seine Arbeitsschwerpunkte liegen im Bereich Digitaler Editionen und Korpora.

Literatur und Forschungsdaten

[1] Christian Thomas: „… ein Gemisch von Gehörtem und selbst Zugeseztem“. Nachschriften der ‚Kosmos-Vorträge‘ Alexander von Humboldts: Dokumentation, Kontextualisierung und exemplarische Analysen. Dissertation, Humboldt-Universität zu Berlin: edoc-Server, Version 1.0 vom 1. November 2023. DOI: https://doi.org/10.18452/27521.

[2] Dieses Korpus wurde im Zuge des Projekts Hidden Kosmos der Humboldt-Universität durchgehend einheitlich im internationalen de facto-Standard der Text Encoding Initiative (TEI) annotiert und im Deutschen Textarchiv (DTA) der Berlin-Brandenburgischen Akademie der Wissenschaften (BBAW) veröffentlicht. Siehe Hidden Kosmos—Reconstructing Alexander von Humboldt’s »Kosmos-Lectures« (2014–2016), Humboldt-Universität zu Berlin, https://www.culture.hu-berlin.de/de/forschung/projekte/hidden-kosmos/; Subkorpus „Alexander von Humboldts Kosmos-Vorträge“ im Deutschen Textarchiv, BBAW, https://www.deutschestextarchiv.de/search/metadata?corpus=avhkv.

[3] Christian Thomas: “You Can’t Put Your Arms Around a Memory: The Multiple Versions of Alexander von Humboldt’s ‘Kosmos-Lectures’ (1827/28).” In: Versioning Cultural Objects. Edited by Roman Bleier and Sean M. Winslow. Schriften des Instituts für Dokumentologie und Editorik, 13. Norderstedt: Books on Demand, 2019, pp. 77–99. https://kups.ub.uni-koeln.de/10650; urn:nbn:de:hbz:38-106501.

Datum: 27.11.2023, 16-18 Uhr

Ort: HU Hauptgebäude, Unter den Linden 6, Raum 2249A

UPDATE: Die Referentinnen werden per Videokonferenz zugeschaltet. Der Vortrag findet hybrid statt. Zugangsdaten für die Videokonferenz erhalten Sie nach Anmeldung per Mail an ub.makerspace@hu-berlin.de

Soziale Medien zählen heutzutage vermutlich zu den nutzer*innen- und reichweitenstärksten Aushandlungsorten geschichtsbezogener, politischer und gesellschaftlicher Diskurse. Bei der Erforschung der Plattformen sehen sich nicht nur Historiker*innen mit technischen, rechtlichen und ethischen Fragen konfrontiert. Insbesondere die Kopplung an globale Konzerne und (große) Datenstrukturen führt zu forschungspraktischen Herausforderungen, die im Vortrag anhand der Plattformen Instagram und TikTok vorgestellt werden sollen. Neben einem grundsätzlichen Problemaufriss sollen mögliche Zugänge zum Material sowie aktuelle Entwicklungen in Forschung und Politik aufgezeigt werden.

Andrea Lorenz ist wissenschaftliche Mitarbeiterin am Arbeitsbereich Public History der Universität Hamburg. Im Rahmen des Verbundprojekts „SocialMediaHistory – Geschichte auf Instagram und TikTok” promoviert Lorenz zu vergangenheitsbezogener Hate Speech.

Mia Berg ist wissenschaftliche Mitarbeiterin im Bereich Geschichtsdidaktik und Public History an der Ruhr-Universität Bochum. Im Projekt SocialMediaHistory untersucht sie gemeinsam mit Bürger*innen, wie Geschichte auf Instagram und TikTok stattfindet, analysiert und produziert werden kann.

Datum: 17.11.2023, 14-16 Uhr

Ort: HU Hauptgebäude, Unter den Linden 6, Raum 3059

UPDATE: Wegen des Bahnstreiks findet der Vortrag hybrid statt. Die Veranstaltung findet wie angekündigt im HU Hauptgebäude statt, die Referentin wird per Videokonferenz zugeschaltet. Bei Bedarf gewähren wir Zugang zur Videokonferenz nach Anmeldung per Mail an ub.makerspace@hu-berlin.de.

Das Digitale hat seinen Ursprung im Programm der Operationalisierung des Geistes der neuzeitlichen Philosophie. Dieses groß angelegte Programm setzt sich bis heute fort und sorgt für die vielfältigen Phänomene des Digitalen. Der Vortrag analysiert die Gründe für den Erfolg dieses Programms, die in den Zeichen- und Werkzeugen der Programmierung, Digitalisierung und Datafizierung liegen. Welche Art an „Zeichenzeug“ braucht es, um das Digitale in Werkzeuge zu überführen? Welcher Art sind diese digitalen Werkzeuge, was leisten sie und wo liegen ihre Grenzen?

Gabriele Gramelsberger hat den Lehrstuhl für Wissenschaftstheorie und Technikphilosophie an der RWTH Aachen inne. Ihr Forschungsthema ist die Transformation von Wissenschaft und Gesellschaft durch die Digitalisierung. Sie ist Mitglied der Nordrhein-Westfälischen Akademie der Wissenschaft und der Künste sowie Direktorin des Käte Hamburger Kollegs c:o/re „Kulturen des Forschens“.

Literatur: Gabriele Gramelsberger, Philosophie des Digitalen zur Einführung, Hamburg: Junius 2023.

Der Vortrag bildet den Auftakt für die Reihe Werkzeug. Zur Praxis computergestützter Forschung in den Geistes- und Kulturwissenschaften. Weitere Vorträge in der Reihe siehe https://hu.berlin/werkzeug.

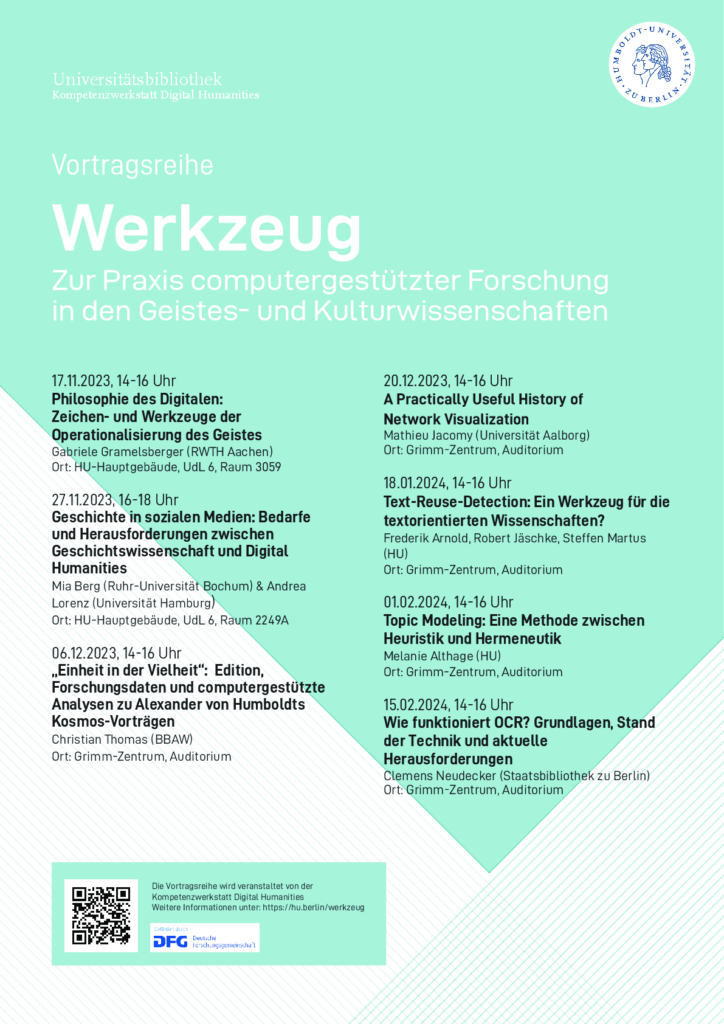

Vortragsreihe im Wintersemester 2023/24

17.11.2023 (Fr) 14-16 Uhr Gabriele Gramelsberger (RWTH Aachen): Philosophie des Digitalen — Zeichen- und Werkzeuge der Operationalisierung des Geistes. Ort: HU Hauptgebäude, Unter den Linden 6, Raum 3059.

27.11.2023 (Mo) 16-18 Uhr Mia Berg (Ruhr-Universität Bochum) und Andrea Lorenz (Universität Hamburg): Geschichte in sozialen Medien: Bedarfe und Herausforderungen zwischen Geschichtswissenschaft und Digital Humanities. Ort: HU Hauptgebäude, Unter den Linden 6, Raum 2249A.

6.12.2023 (Mi) 14-16 Uhr Christian Thomas (Berlin-Brandenburgische Akademie der Wissenschaften): Einheit in der Vielheit: Edition, Forschungsdaten und computergestützte Analysen zu Alexander von Humboldts Kosmos-Vorträgen. Ort: Grimm-Zentrum, Auditorium.

20.12.2023 (Mi) 14-16 Uhr Mathieu Jacomy (Universität Aalborg): A practically useful history of network visualization. Ort: Grimm-Zentrum, Auditorium. Vortrag und Gespräch englisch.

18.1.2024 (Do) 14-16 Uhr Frederik Arnold, Robert Jäschke, Philip Kraut, Steffen Martus (Humboldt-Universität zu Berlin): Text-Reuse-Detection: Ein Werkzeug für die textorientierten Wissenschaften? Ort: Grimm-Zentrum, Auditorium.

1.2.2024 (Do) 14-16 Uhr ENTFÄLLT Melanie Althage (Humboldt-Universität zu Berlin): Topic Modeling: Eine Methode zwischen Heuristik und Hermeneutik. Ort: Grimm-Zentrum, Auditorium.

15.2.2024 (Do) 14-16 Uhr Clemens Neudecker (Staatsbibliothek zu Berlin): Wie funktioniert OCR? Grundlagen, Stand der Technik und aktuelle Herausforderungen. Ort: Grimm-Zentrum, Auditorium.

Die meisten Veranstaltungen finden hybrid statt. Zugangsdaten für die einzelnen Vorträge schicken wir nach Anmeldung per Mail an ub.makerspace@hu-berlin.de.

Der Einsatz computergestützter Werkzeuge in den Geistes- und Kulturwissenschaften sorgt für weitreichende Veränderungen, Ergänzungen und Ausdifferenzierungen geistes- und kulturwissenschaftlicher Forschung. Mit „Werkzeug“ sind dabei meist Programme gemeint, die auf je unterschiedliche Weise computergestützte Methoden für die Forschung und allgemeiner für den Umgang mit digitalen Gegenständen verfügbar machen. Eng verbunden ist das Werkzeug mit seiner Anwendung. Es ist dabei nicht nur Mittel zum Zweck, sondern arbeitet an der Gestaltung von Arbeitsabläufen und am Verhältnis zum Gegenstand mit. Zu einem instrumentellen Wissen, das für die Anwendung unabdingbar ist, tritt damit eine erkenntnis- und mediengeschichtliche Dimension, die das Werkzeug in seiner Entwicklung auch als Bedingung wissenschaftlicher Arbeit sichtbar werden lässt. Die Reihe stellt vor diesem Hintergrund ausgewählte computergestützte Ansätze in den Geistes- und Kulturwissenschaften vor. Die Vorträge verbinden dabei eine praxisorientierte Darstellung von konkreten Anwendungsfällen, Methoden und Werkzeugen mit einer erkenntniskritischen Reflexion, historischen Einordnung und praxeologischen Perspektive.

Abstracts

17.11. (Fr) 14-16 Uhr Gabriele Gramelsberger (RWTH Aachen): Philosophie des Digitalen — Zeichen- und Werkzeuge der Operationalisierung des Geistes. Ort: HU Hauptgebäude, Unter den Linden 6, Raum 3059.

Das Digitale hat seinen Ursprung im Programm der Operationalisierung des Geistes der neuzeitlichen Philosophie. Dieses groß angelegte Programm setzt sich bis heute fort und sorgt für die vielfältigen Phänomene des Digitalen. Der Vortrag analysiert die Gründe für den Erfolg dieses Programms, die in den Zeichen- und Werkzeugen der Programmierung, Digitalisierung und Datafizierung liegen. Welche Art an „Zeichenzeug“ braucht es, um das Digitale in Werkzeuge zu überführen? Welcher Art sind diese digitalen Werkzeuge, was leisten sie und wo liegen ihre Grenzen?

Gabriele Gramelsberger hat den Lehrstuhl für Wissenschaftstheorie und Technikphilosophie an der RWTH Aachen inne. Ihr Forschungsthema ist die Transformation von Wissenschaft und Gesellschaft durch die Digitalisierung. Sie ist Mitglied der Nordrhein-Westfälischen Akademie der Wissenschaft und der Künste sowie Direktorin des Käte Hamburger Kollegs c:o/re „Kulturen des Forschens“.

Literatur: Gabriele Gramelsberger, Philosophie des Digitalen zur Einführung, Hamburg: Junius 2023.

27.11. (Mo) 16-18 Uhr Mia Berg (Ruhr-Universität Bochum) und Andrea Lorenz (Universität Hamburg): Geschichte in sozialen Medien: Bedarfe und Herausforderungen zwischen Geschichtswissenschaft und Digital Humanities. Ort: HU Hauptgebäude, Unter den Linden 6, Raum 2249A.

Soziale Medien zählen heutzutage vermutlich zu den nutzer*innen- und reichweitenstärksten Aushandlungsorten geschichtsbezogener, politischer und gesellschaftlicher Diskurse. Bei der Erforschung der Plattformen sehen sich nicht nur Historiker*innen mit technischen, rechtlichen und ethischen Fragen konfrontiert. Insbesondere die Kopplung an globale Konzerne und (große) Datenstrukturen führt zu forschungspraktischen Herausforderungen, die im Vortrag anhand der Plattformen Instagram und TikTok vorgestellt werden sollen. Neben einem grundsätzlichen Problemaufriss sollen mögliche Zugänge zum Material sowie aktuelle Entwicklungen in Forschung und Politik aufgezeigt werden.

Andrea Lorenz ist wissenschaftliche Mitarbeiterin am Arbeitsbereich Public History der Universität Hamburg. Im Rahmen des Verbundprojekts „SocialMediaHistory – Geschichte auf Instagram und TikTok” promoviert Lorenz zu vergangenheitsbezogener Hate Speech.

Mia Berg ist wissenschaftliche Mitarbeiterin im Bereich Geschichtsdidaktik und Public History an der Ruhr-Universität Bochum. Im Projekt SocialMediaHistory untersucht sie gemeinsam mit Bürger*innen, wie Geschichte auf Instagram und TikTok stattfindet, analysiert und produziert werden kann.

6.12. (Mi) 14-16 Uhr Christian Thomas (BBAW): Einheit in der Vielheit: Edition, Forschungsdaten und computergestützte Analysen zu Alexander von Humboldts Kosmos-Vorträgen. Ort: Grimm-Zentrum, Auditorium.

Der Vortrag präsentiert die wichtigsten Ergebnissen meiner kürzlich an der Humboldt-Universität zu Berlin erschienenen Dissertation sowie die zu deren Erarbeitung angewandten Methoden. Die Präsentation fokussiert auf den Einsatz verschiedener Werkzeuge aus dem Bereich des Natural Language Processing (NLP) sowie im weiteren Sinne der Digital Humanities (DH) zur Bearbeitung und heuristischen Beantwortung literatur- und editionswissenschaftlicher Fragestellungen. Analysiert wird ein etwa 3500 handschriftliche Seiten umfassendes Volltextkorpus zu Alexander von Humboldts sogenannten Kosmos-Vorträgen (Berlin, 1827/28). Da Manuskripte des Vortragenden nicht vollständig und nicht in ihrer ursprünglichen Form überliefert sind, stellen die im Korpus enthaltenen Mitschriften, Nachschriften und deren Abschriften aus dem Kreis der Hörerinnen und Hörer die wichtigsten Quellen zu den Inhalten der Kosmos-Vorträge dar.

Christian Thomas ist Wissenschaftlicher Mitarbeiter im Akademienvorhaben „Alexander von Humboldt auf Reisen – Wissenschaft aus der Bewegung“ an der Berlin-Brandenburgischen Akademie der Wissenschaften sowie im Akademienvorhaben „Propyläen – Goethes Biographica“ an der Klassik Stiftung Weimar. Seine Arbeitsschwerpunkte liegen im Bereich Digitaler Editionen und Korpora. Web: https://www.bbaw.de/die-akademie/mitarbeiterinnen-mitarbeiter/thomas-christian/

Literatur: Christian Thomas: „… ein Gemisch von Gehörtem und selbst Zugeseztem“. Nachschriften der ‚Kosmos-Vorträge‘ Alexander von Humboldts: Dokumentation, Kontextualisierung und exemplarische Analysen. Dissertation, Humboldt-Universität zu Berlin: edoc-Server, Version 1.0 vom 1. November 2023. DOI: 10.18452/27521.

20.12. (Mi) 14-16 Uhr Mathieu Jacomy (Universität Aalborg): A practically useful history of network visualization. Ort: Grimm-Zentrum, Auditorium. Vortrag und Gespräch auf englisch.

This talk is about the science of visualizing networks. Although the field of graph drawing, as we call it, has no shortage of theoretical contributions, those have always followed practices; and with a sensible delay. Mathieu Jacomy, co-founder of the network visualization tool Gephi, will sketch the double story of the craftsmanship and the academic evaluation of representing networks as dots and lines, from Jacob Moreno’s sociograms, to Peter Eades‘ first force-driven layout algorithms, to Helen Purchase’s aesthetic criteria, and finally to the data deluge and the availability of large complex networks, paving the way to network science. This story will show how practices shape cultures in ways that escape the control of academics, at once bad and good, uninformed yet innovative, unjustified yet meaningful. Reading a large complex network is not the same as a small diagram, and the talk will provide illustrations of the ideas that had to be left behind to properly frame graph drawing as a mediation driven by technology. Which will also help you read large network maps properly.

Mathieu Jacomy is Doctor of Techno-Anthropology and assistant professor at the Aalborg University Tantlab, and MASSHINE center. He was a research engineer for 10 years at the Sciences Po médialab in Paris, and is a co-founder of Gephi, a popular network visualization tool. He develops digital instruments involving data visualization and network analysis for the social science and humanities. His current research focuses on visual network analysis, digital controversy mapping, and computational social science. He toots at @jacomyma@mas.to and blogs at reticular.hypotheses.org.

18.1. (Do) 14-16 Uhr Frederik Arnold, Robert Jäschke, Philip Kraut, Steffen Martus (HU Berlin): Text-Reuse-Detection: Ein Werkzeug für die textorientierten Wissenschaften? Ort: Grimm-Zentrum, Auditorium.

Zitate sind ein wichtiges Indiz für intertextuelle Verhältnisse. Insbesondere direkte, wörtliche Übernahmen weisen auf Stellen hin, die so bedeutend sind, dass sie nicht in ‘eigenen Worten’ wiedergegeben werden können oder durch eigene Worte ersetzt werden sollen. In unseren Projekten zur Identifikation von “Schlüsselstellen” sowie zur (Nach-)Nutzung vorhandenen Expert*innenwissens in den Computational Literary Studies haben wir Verfahren zur Text-Reuse-Detection entwickelt, die sich insbesondere auf die bislang systematisch ungeklärte Beziehung von Quellen und wissenschaftlichen Texten konzentrieren, aber auch andere Formen von Intertextualität erfassen.

Steffen Martus ist Professor für Neuere deutsche Literatur am Institut für deutsche Literatur der Humboldt–Universität zu Berlin. Seine Forschungsschwerpunkte liegen in der Literaturgeschichte vom 18. Jahrhundert bis zur Gegenwart, in der Literaturtheorie (insbesondere Theorien des literarischen Werks) sowie der Wissenschaftstheorie und -geschichte der Geisteswissenschaften. Im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies leitet er gemeinsam mit Rober Jäschke ein Projekt zu Schlüsselstellen in der Literatur (2020-2026). Gemeinsam mit Jörn Kreutel (Berliner Hochschule für Technik) leitet er das DFG-Projekt „Forschungsplattform Literarisches Feld DDR: Autor*innen, Werke, Netzwerke“.

Robert Jäschke ist Professor für Information Processing and Analytics am Institut für Bibliotheks- und Informationswissenschaft der Humboldt-Universität zu Berlin. Sein Forschungsschwerpunkt sind Verfahren (vorrangig des maschinellen Lernens) zur Verarbeitung und Analyse großer Datenmengen. Beispielsweise erforscht er im DFG-Projekt Unknown Data (2022-2025) Verfahren zum Finden und Katalogisieren von Long-Tail-Forschungsdaten der Informatik und der Sozialwissenschaften. Im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies leitet er gemeinsam mit Steffen Martus ein Projekt zu Schlüsselstellen in der Literatur (2020-2026). Robert Jäschke ist Mitbegründer des Social-Bookmarking-Dienstes BibSonomy und Gründer und Mitherausgeber des Blogs weltliteratur.net, einem „Schwarzmarkt für die Digitalen Geisteswissenschaften“.

Frederik Arnold ist akademischer Mitarbeiter am Lehrstuhl für Information Processing and Analytics am Institut für Bibliotheks- und Informationswissenschaft. Er forscht im Rahmen des DFG-Schwerpunktprogramms 2207 Computational Literary Studies zu Schlüsselstellen in der Literatur mit Fokus auf der automatisierten Entdeckung. Er hat seinen Master in Computerlinguistik an der Universität des Saarlandes erworben.

1.2. (Do) 14-16 Uhr Entfällt Melanie Althage (HU Berlin): Topic Modeling: Eine Methode zwischen Heuristik und Hermeneutik. Ort: Grimm-Zentrum, Auditorium.

Topic Modeling ist eine in den digitalen Geistes- und Geschichtswissenschaften etablierte Methode zur Exploration und quantitativen Analyse umfangreicher Textkorpora. Sie ermöglicht die automatisierte Identifikation gemeinsamer Sprachgebrauchsmuster, die wie Themen, Motive oder Diskurse interpretiert werden können. Allerdings gehen mit Topic Modeling auch einige methodologische und epistemologische Herausforderungen einher. Vor diesem Hintergrund wird der Vortrag aus geschichtswissenschaftlicher und methodenkritischer Perspektive die Potenziale und Grenzen von Topic Modeling diskutieren und einen Workflow vorschlagen. Dazu wird einerseits in die Grundprinzipien der Methode eingeführt und die Entwicklungsgeschichte skizziert sowie andererseits ein Überblick über den aktuellen Entwicklungsstand gegeben. Betont wird zudem die Relevanz des Preprocessings der Textdaten sowie die kritische Beurteilung der Modellierungsergebnisse.

Melanie Althage ist wissenschaftliche Mitarbeiterin an der Professur für Digital History (Institut für Geschichtswissenschaften, Humboldt-Universität zu Berlin). In ihrem Dissertationsprojekt widmet sie sich der methodenkritischen Untersuchung der Adaptierbarkeit etablierter Textanalysemethoden der Digital Humanities und Computerwissenschaften für historische Quellen und Forschungsfragen am Beispiel der digitalen historischen Fachkommunikation. Ziel ist dabei die Etablierung einer Methodenkritik als Erweiterung der historisch-kritischen Methode der Geschichtswissenschaften.

15.2. (Do) 14-16 Uhr Clemens Neudecker (Staatsbibliothek zu Berlin): Wie funktioniert OCR? Grundlagen, Stand der Technik und aktuelle Herausforderungen. Ort: Grimm-Zentrum, Auditorium.

Texterkennung (Optical Character Recognition, OCR) ist die Technologie um aus Scans (also Bildern) von Dokumenten digitale, editierbare und durchsuchbare Volltexte zu erzeugen. Sowohl durch Digital Humanities als auch Künstliche Intelligenz steigt der Bedarf von Wissenschaft und Forschung an digitalen Texten. Jedoch ist die Texterkennung, insbesondere für historische Dokumente, noch stets eine sowohl technisch als auch organisatorisch hoch komplexe Aufgabe. Der Vortrag hat daher zum Ziel die Grundlagen, technischen Verfahren und den aktuellen Stand der Entwicklungen im Bereich der OCR vorzustellen um so einen gründlichen Überblick über die Möglichkeiten und Herausforderungen zu geben. Dabei werden neben Ursprung und Geschichte der OCR insbesondere die vielfältigen Verarbeitungsschritte in einem typischen OCR-Workflow, die besonderen Anforderungen von historischem Material sowie aktuelle Forschungsprojekte und technologische Entwicklungen im Zentrum stehen.

Clemens Neudecker arbeitet als Forscher, Projektmanager und Library Hacker an der Staatsbibliothek zu Berlin. Er ist dort unter anderem eingebunden in das umfangreiche Verbundprojekt OCR-D. Seine Arbeitsschwerpunkte sind Computer Vision, Natural Language Processing, Machine Learning & Artificial Intelligence und ihr Einsatz in den Bereichen Digitale Bibliotheken und Digital Humanities.

Passend zum Vortrag bietet die Kompetenzwerkstatt Digital Humanities einen Workshop zur praktischen Einführung in die Arbeit mit der Software OCR4all an, die u.a. Technologien bereitstellt, die im Projekt OCR-D entwickelt werden.

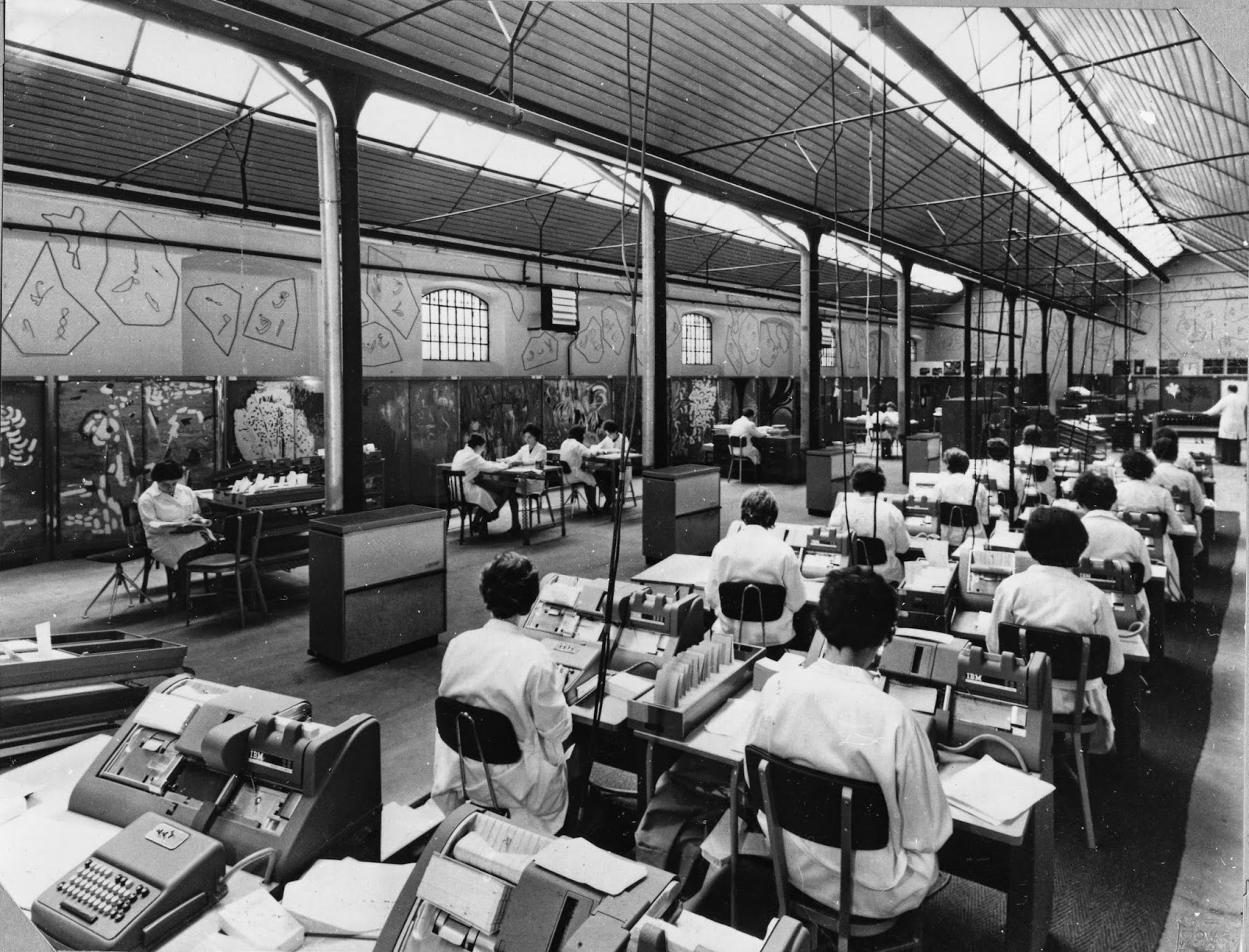

Das Bild im Header stammt aus den Materialien zum Großprojekt „Index Thomisticus“ in den 1950er/1960er Jahren und zeigt eine große Gruppe Codiererinnen, die im Projekt für die Codierung des Texts auf Lochkarten verantwortlich waren.

Lizenz CC-BY-NC CIRCSE Research Centre, Università Cattolica del Sacro Cuore, Milan, Italy. Erstpublikation in Melissa Terras: For Ada Lovelace Day – Father Busa’s Female Punch Card Operatives, 15.10.2013, https://melissaterras.org/2013/10/15/for-ada-lovelace-day-father-busas-female-punch-card-operatives/, archiviert: https://web.archive.org/web/20231101155001/https://melissaterras.org/2013/10/15/for-ada-lovelace-day-father-busas-female-punch-card-operatives/ .

Termin: Mittwoch, 29.11.2023, 9:00-12:30 Uhr

Ort: Humboldt-Universität, Campus Mitte

Anmeldung per Email an ub.makerspace@hu-berlin.de

Teilnahmebegrenzung: 20 Teilnehmer*innen

Generative KI-Systeme wie ChatGPT stellen für die Lehre eine Herausforderung dar. Sowohl die Ergebnisqualität als auch die Verfügbarkeit haben sich in jüngster Zeit signifikant gesteigert. Gleichzeitig fehlt es noch an begründeten Regularien und didaktischen Konzepten im Umgang mit diesen Systemen in der Lehre. In Zusammenarbeit mit dem Projekt AI Skills und dem Methods Innovation Lab von NFDI4Memory bietet die Kompetenzwerkstatt Digital Humanities an der UB der Humboldt-Universität einen Workshop für Lehrende an, der Bedarfe in diesem Bereich adressiert:

a) KI-Anwendungen ausprobieren, einschätzen, analysieren

b) Regeln für die Arbeit mit ChatGPT und anderen Anwendungen festlegen

c) Mit dem möglichen Einsatz von KI-Anwendungen durch Studierende umgehen

d) Übungseinheiten gestalten für Kompetenzvermittlung und kritische Reflexion

Die Veranstaltung schafft einen Raum, in dem Lehrende ausgewählte generative KI-Anwendungen ausprobieren, kritisch diskutieren und gemeinsam Lösungsansätze für den Umgang mit solchen Systemen in der Lehre entwickeln. Die Veranstaltung setzt auf eine moderierte gemeinsame Problemanalyse und Lösungsfindung. Teilnehmer*innen sind eingeladen, Fragen, Problematiken und Beobachtungen aus der eigenen Lehrpraxis einzubringen. Hinzu kommen kurze Inputs und angeleitete Übungen zur Vermittlung grundlegender Kenntnisse und Umgangsformen mit generativen Systemen. Es werden keine technischen Kenntnisse vorausgesetzt, sondern lediglich die Bereitschaft, sich in einem moderierten kollaborativen Format aktiv zu beteiligen.

Die Veranstaltung richtet sich an Lehrende der Humboldt-Universität zu Berlin, vorrangig in den Geistes- und Kulturwissenschaften. Die Anzahl der Teilnehmer*innen ist auf 20 begrenzt. Bitte melden Sie sich per Mail an ub.makerspace@hu-berlin.de an. Fragen beantworten wir ebenfalls gerne per Mail.

Der Workshop wird gemeinsam veranstaltet von: Kompetenzwerkstatt Digital Humanities, AI Skills und NFDI4Memory Methods Innovation Lab.

Bild: DALL-E 2, „A student and a teacher, side by side in front of their laptops, working with an Artificial Intelligence taking the form of a giant cheat sheet, pencil sketch“.