In den letzten Jahren erreichten uns verstärkt Nachfragen zu Clustern, Computer-Ressourcen und dedizierten Servern. Der „Clou-Cluster“ der HU ist mit einem Alter von sechs Jahren bzgl. der Ausstattung und den Software-Versionen nicht mehr aktuell. Durch die Heterogenität der angefragten Szenarien können diese kaum und nur mit einem hohen Personalaufwand durch einen einheitlichen Cluster abgedeckt werden.

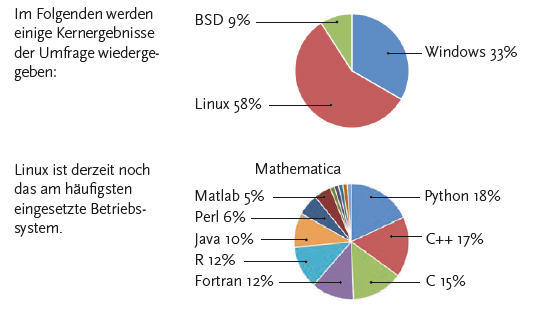

Vor diesem Hintergrund haben wir eine Umfrage durchgeführt, die den aktuellen und zukünftigen Bedarf etwas strukturierter erfassen soll. Es gab insgesamt fast 30 Rückmeldungen, die sehr deutlich aufzeigen, wie heterogen die Bedarfe mittlerweile geworden sind. Die Angaben reichen von klassischen HPC-Szenarien über Video-Auswertungen, 3D-Visualisierungen oder Bildanalysen bis hin zu Textverarbeitung, -prozessierung und -analyse.

Es soll nicht unerwähnt bleiben, dass die Umfrage keine exakte und vollständige Erhebung des Gesamtbedarfs an Rechenkapazität an der HU darstellt, sondern eher ein Meinungsbild und den groben Trend der Entwicklung erfassen sollte.

Die am häufigsten genannte Sprache ist Python, gefolgt von C++, C, Fortran, R und Java, wobei 55% der Antworten selbstgeschriebene Software und 45% kommerzielle Software genannt haben.

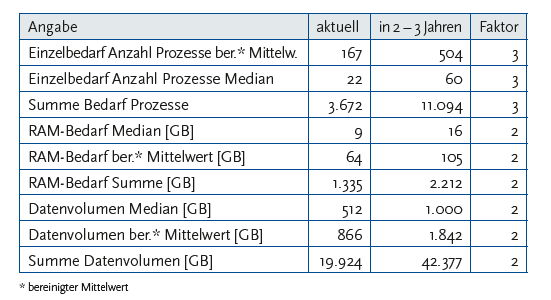

Kern der Umfrage war die Abschätzung der benötigten Ressourcen zurzeit und in 2 bis 3 Jahren. Hier ergibt sich im Vergleich ein Faktor von 2 – 3 bzgl. der Ressourcenbedarfe. Derzeit sind es im bereinigten Mittel 167 Prozesse pro Nutzung gegenüber 504 Prozessen in 2 bis 3 Jahren. Beim RAM-Bedarf werden derzeit im Mittelwert 64 GB benötigt, zukünftig 105 GB. Die Größe der zu verarbeitenden Daten beträgt zurzeit im Mittel noch 866 GB gegenüber 1.842 GB in der Abschätzung für die nächsten zwei bis drei Jahre, der Median beträgt hier 512 und 1.000 GB.

In der Summe ergibt sich dadurch mit den 30 Antworten ein – nicht gleichzeitiger – Prozessbedarf von 3.672 Prozessen heute zu 11.094 Prozessen in der Zukunft. Der RAM-Bedarf für alle Antworten steigt von 1.335 GB auf 2.212 GB und die Gesamtmenge der Daten von derzeit 19.924 GB auf 42.377 GB in zwei bis drei Jahren.

Die folgende Tabelle fasst die Daten noch einmal zusammen:

Zum Ergebnis möchten wir mit den Fakultäten diskutieren, welche Lösungen zur Verbesserung der Situation vorstellbar sind. Bei einer Verdopplung bzw. Verdreifachung der benötigten Ressourcen alle zwei bis drei Jahre und der möglichen Betriebsdauer von Servern bis zu 5 bis 7 Jahren würde sich ein Beschaffungsbedarf von mindestens dem vierfachen Betrag der dargestellten Bedarfe ergeben. Hierdurch wird deutlich, dass mit den vorhandenen Etats dieses Problem nicht umfassend adressiert werden kann. Projiziert man alle Antworten z. B. auf den Median der Meldungen, ergibt sich ein aufsummierter Bedarf von ca. 500 – 1000 Prozessen, 200 – 400 GB RAM-Bedarf und 12 – 24 TB an Datenvolumen. Diese Mengen erscheinen auf den ersten Blick finanziell erreichbar und diese zusätzlichen Ressourcen könnten z. B. in die HU-Cloud integriert werden. Wir hoffen jedoch, dass sich in den Diskussionen auch pragmatische Ansätze und Lösungen für die darüber hinausgehenden Szenarien und Bedarfsmeldungen finden lassen.