OpenIRIS – Online-Plattform zum Entdecken, Teilen und Buchen von Forschungsinfrastruktur

Wissenschaftliche Erfolge sind in immer stärkerem Ausmaß von der zeitnahen Verfügbarkeit immer komplexerer Technologien und Forschungsdienstleistungen abhängig, die nicht jeder im eigenen Institut und Labor vorhalten kann. Darüber hinaus werden die Innovationszyklen dieser Technologien immer kürzer und erfordern apparative und personelle Anpassungen.

Um eine bestmögliche Forschungsumgebung in der BUA zu realisieren und die vorhandenen Ressourcen aller Verbundpartnerinnen sichtbar und nutzbar zu machen, haben die Leitungen aller vier Häuser (das sog. Board of Directors) die Einführung der Online-Plattform OpenIRIS für die BUA beschlossen.

Open IRIS ist eine nicht-kommerzielle Online-Plattform, die Forschenden die Entdeckung und gemeinsame Nutzung von Forschungsressourcen ermöglichen soll. Sie dient als eine Sammlung von Tools und Best Practices für das Ressourcenmanagement und dessen Optimierung.

Mit Hilfe von OpenIRIS soll für die BUA eine gemeinsame und sichtbare Plattform entstehen, um vorhandene Core Facilities, öffentlich finanzierte Großgeräte (z. B. nach 91b GG über die DFG beantragt und gefördert) und Forschungsdienstleistungen transparent darzustellen und nutzbar zu machen. Das Portal wird einen „single point of entry“ darstellen und ein interaktiver Ort werden, in dem die Wissenschaftler*innen des Verbundes vorhandene Forschungsinfrastrukturen aller vier Häuser identifizieren und Nutzungsanfragen stellen können.

In einigen Fällen ist auch eine direkte Buchung von Leistungen vorgesehen.

OpenIRIS als gemeinsame Plattform kann somit die Grundlage für eine gemeinsame strategische Planung von neuen bzw. der Erweiterung von bereits vorhandenen Infrastrukturen dienen.

Sollten Sie mehr über OpenIRIS erfahren wollen oder wenn Sie Interesse haben, OpenIRIS zu nutzen, wenden Sie sich gerne an: openiris@berlin-university-alliance.de.

HU: https://hub.openiris.io

BUA: https://bua.openiris.io

Föderatives Identitätsmanagement für Lehr-Lern-Szenarien

Hochschulübergreifende Kooperationen in Lehre und Studium werden immer wichtiger, ob es Verbünde sind oder bilaterale Studiengänge. Grundlage für kooperative Lehr-Lern-Szenarien ist ein übergreifendes Identitätsmanagement.

Mit Unterstützung des Berliner Senats (Förderlinie QIO) arbeiten HU, FU und UdK bis Ende 2024 an einem gemeinsamen rechtlichen, technischen und organisatorischen Rahmenwerk für das Land Berlin und das Netzwerk seiner Hochschulen. Die Klärung der rechtlichen Rahmenbedingungen ist

grundlegend, um die Übertragung von Daten aus den jeweiligen Lehr-Lern-Systemen überhaupt zu ermöglichen. Auf technischer Ebene müssen abgestimmte Standards entwickelt werden. Zum Teil gibt es bereits Vorbilder in anderen Bundesländern, zum Teil müssen die in den Digitalsemestern gewachsenen Anforderungen sowie die spezifischen Kooperationsszenarien im Wissenschaftsraum Berlin berücksichtigt werden.

Durch das Berliner Verbundprojekt werden die Hochschulen des Landes in die Lage versetzt, ihre Zusammenarbeit nach innen und außen zu vertiefen und Lehrenden und Studierenden neue Dienste anzubieten.

Datenmanagementplanung einfach und individuell: Das Tool RDMO

Datenmanagementplanung gehört inzwischen bei vielen Forschungsförderern verpflichtend zu einem Projektantrag. Die Anforderungen und Formalia der einzelnen Organisationen und Fachbereiche variieren jedoch stark. Um einfach und effizient passgenaue Texte für z. B. Förderprogramme der Europäischen Kommission oder der Deutschen Forschungsgemeinschaft zu verfassen, führt der CMS aktuell ein Tool zur Datenmanagementplanung ein. Viele Forschende hatten sich ein solches Angebot im Rahmen der Bedarfserhebung im letzten Jahr gewünscht (vgl. S. 44 Beitrag von Denise Jäckel). Der Research Data Management Organiser (RDMO) schließt somit eine Lücke im Serviceportfolio des CMS und bietet den Forschenden einen wichtigen Mehrwert: angepasste Templates für Forschungsförderer, Fachbereiche und Großprojekte.

Die Open-Source-Software RDMO wird bereits an mehr als 45 Einrichtungen in Deutschland eingesetzt und von einer breiten Community getragen. Die Aktualisierung und Erweiterung der Templates muss dadurch nicht allein durch den CMS geleistet werden, sondern kann gemeinsam mit Kolleg*innen aus ganz Deutschland erfolgen. Mehr über RDMO: https://rdmorganiser.github.io

Die Initiative HPC@HU

Hochleistungsrechnen ist in der letzten Dekade zu einer der Basistechnologien wissenschaftlicher Forschung geworden. High Performance Computing (HPC) ist derzeit an der HU nicht als zentrale Dienstleistung, sondern in Form von verteilten, separat genutzten und betreuten Installationen an den Lehrstühlen etabliert. Gleichzeitig steigt der Bedarf für HPC in allen Disziplinen. Im Vergleich zur nationalen und regionalen HPC-Infrastruktur ist bei lokalen HPC-Angeboten die Niederschwelligkeit des Zugriffs das wichtigste Kriterium. Deshalb soll an der HU ein zentrales HPC-Angebot in drei Phasen aufgebaut werden.

Zu Beginn wird ein Proof-of-Concept umgesetzt, der für die Austarierung der konkreten Bedarfe an der HU genutzt werden kann. Neben der Planung der HPC-Komponenten und der Schaffung von Personalkapazität sind auch der Ausbau der Serverräume sowie Strom- und Kälteversorgung wichtige Vorbedingungen für dieses Vorhaben.

Ziel ist die Etablierung von HPC-Services für die HU bzw. ein kontinuierlich ausgebautes Angebot für alle wissenschaftlichen Bereiche. Hierbei sollen nicht nur klassische HPC-Szenarien berücksichtigt, sondern auch ein niederschwelliger Einstieg zur Nutzung für HU-Forschende geschaffen werden, die bisher noch keinen Kontakt zu HPC-Angeboten hatten.

Relaunch der HU-Webseiten

Endlich: Die HU-Webseiten werden einem umfassenden Relaunch unterzogen. Das Projekt gliedert sich in die Teilprojekte „Pilotierung“ (Festlegung der gestalterisch-konzeptionellen Grundlagen) und „Rollout und Betrieb“ (Modernisierung der Infrastruktur für den Betrieb des Content-Management-Systems).

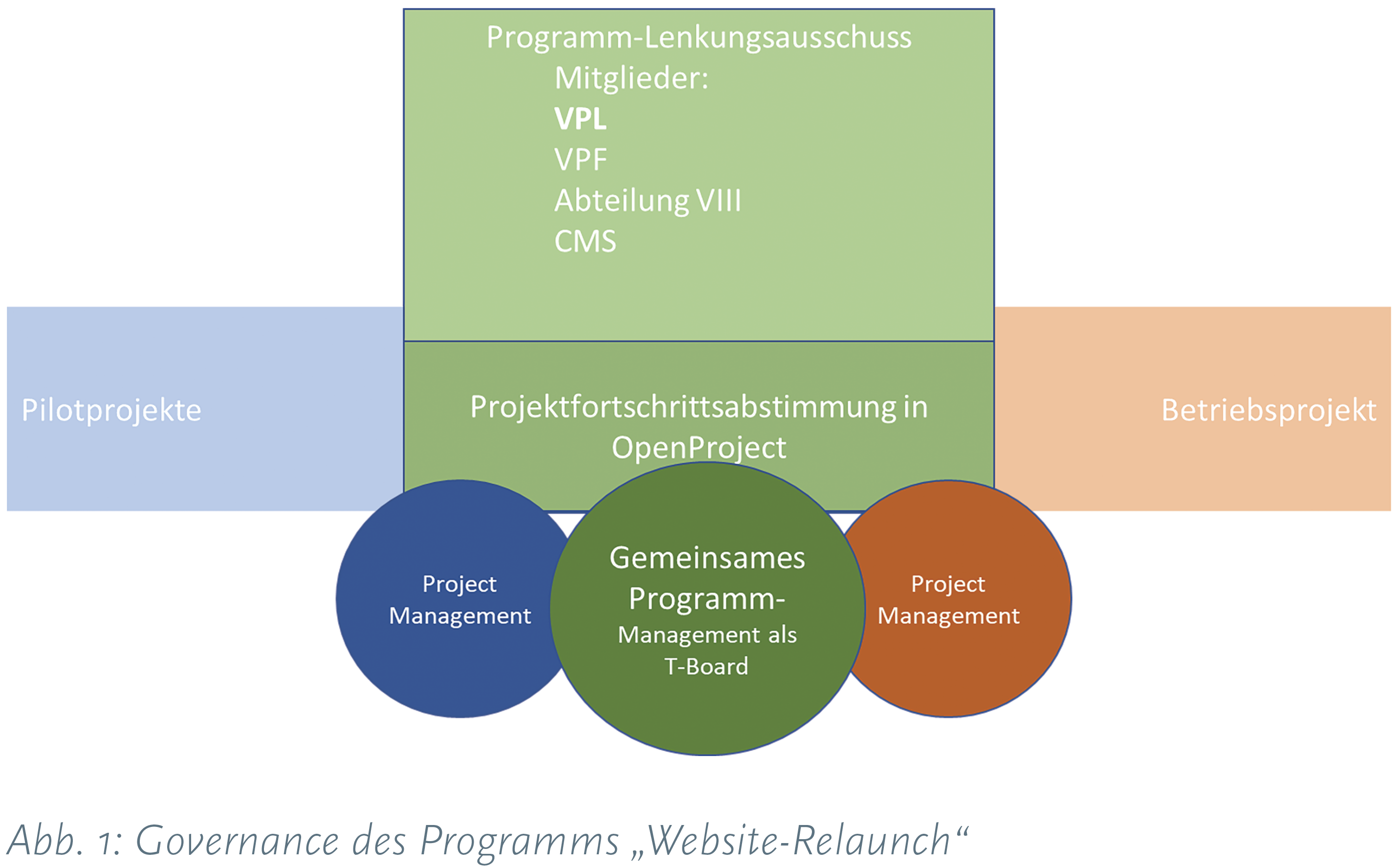

Die Führung des Gesamtprojektes übernimmt eine Steuerungsgruppe unter Leitung des Vizepräsidenten für Studium und Lehre, siehe Abb. 1.

Hauptverantwortlich für das Teilprojekt II ist der Computer- und Medienservice. Er trägt als zentraler IT-Dienstleister die Verantwortung für eine zeitgemäße technische Umsetzung des neuen Webauftritts. Vertreten durch die technische Projektleitung begleitet er das Projekt durch die unterschiedlichen Phasen und erarbeitet auf Basis der im Projekt festgestellten Bedarfe ein nachhaltiges Technologiekonzept. Außerdem bereitet er unter Berücksichtigung sicherheitsrelevanter Aspekte ein Einführungs- und Betriebskonzept vor. In Zusammenarbeit mit externen Dienstleistern realisiert er die Anbindung weiterer Systeme.

Projektphasen des Teilprojekts II

- Konzeption der Architektur und Bereitstellung eines neuen Web-Content-Management-Systems

- Übertragung des neuen Layouts in technische Komponenten

- Entwicklung von Extensions und der Sourcing-Struktur

- Erprobung der Migration von Inhalten aus anderen Systemen

- Übertragung des neuen Layouts auf weitere Anwendungen

Derzeit laufen die ersten Tests zur Eignung von TYPO3 mit einer modernen Headless-Oberfläche. Eine lauffähige Umgebung wird nicht vor Juli 2023 zur Verfügung stehen.

Machine Learning zur textbasierten Klassifikation von Forschungsinformationen

Im Rahmen des Projekts „Forschungsinformationsplattform mit VIVO“ (FIP mit VIVO) kommt maschinelles Lernen zum Einsatz, um innerhalb der Berlin University Alliance (BUA) Forschungsinformationen aus Webseiten und Forschungsdokumenten automatisiert zu extrahieren und zu klassifizieren.

Forschungsinformationen (FI) sind Metadaten zu Projekten, Datensätzen, Publikationen, Forschungsgruppen und mehr. Mit Hilfe von FI können diese in Kategorien eingeteilt, der Suchprozess erleichtert, die Qualität der Suchergebnisse verbessert und weitere relevante Ergebnisse vorgeschlagen werden. Machine-Learning-Technologien ermöglichen es, Texte auf Webseiten oder in Dokumenten zu analysieren und FI automatisch zu extrahieren, zu strukturieren und zu klassifizieren. Dazu kommt Natural Language Processing (NLP) zum Einsatz – eine Technologie des maschinellen Lernens, die Algorithmen zur Verarbeitung und Analyse großer Mengen von Sprache bereitstellt.

Im Rahmen des Projekts „FIP mit VIVO“ wird ein Ansatz entwickelt, um FI von Webseiten oder aus Forschungsoutputs automatisiert zu extrahieren und zu kategorisieren. Dazu werden Texte mittels Textextraktion automatisch gescannt und analysiert, um Entitäten wie Namen und Organisationen, spezifische Informationen wie Forschungsschwerpunkte und -gebiete oder vordefinierte Schlagwörter zu extrahieren.

Die Textklassifizierung ermöglicht eine automatische Kategorisierung der extrahierten Informationen unter vordefinierten Tags oder Gruppierungen. Sie ermöglicht es auch, Texte über ihren Kontext zu kategorisieren, ohne dass vordefinierte Kategorien explizit im Text vorhanden sind. Dazu wird eine Reihe von vordefinierten Kategorien verwendet, z. B. Disziplinen, Fachgebiete und interdisziplinäre Forschungsfelder. Die Entitäten dieser Kategorien werden häufig in so genannten Taxonomien angeordnet, die in maschinenverständliche Ontologien umgewandelt werden können. So können FI nach Disziplinen und interdisziplinären Forschungsfeldern kategorisiert und verbunden werden. Diese Klassifizierung erleichtert das Durchsuchen relevanter Informationen und den Zugriff auf Forschungsarbeiten, etwa innerhalb einer Disziplin. Sie liefert darüber hinaus wichtige Informationen für die strategische Forschungsplanung.

Dieser Ansatz soll zukünftig durch weitere Klassifizierungsmethoden ergänzt werden, so dass unterschiedliche Filter noch präzisere Suchergebnisse ermöglichen und Texte in deutscher und englischer Sprache analysiert werden können.