Malte Dreyer

Direktor Computer- und Medienservice

Seit der Einführung von ChatGPT hat die Humboldt-Universität zu Berlin konsequent an der Entwicklung eigener KI-Dienste gearbeitet. Der Artikel beschreibt den Weg von ersten lokalen Sprachmodellen bis zum heutigen umfassenden KI-Ökosystem, das Forschung, Lehre und Verwaltung unterstützt.

Einführung und Entwicklung der KI-Services

Als im November 2022 ChatGPT veröffentlicht wurde, hat dies auch im CMS großes Interesse gefunden. Wir haben daraufhin ab Mai 2023 mit den ersten lokal bereitgestellten großen Sprachmodellen (Large Language Models – LLMs) innerhalb von HPC@HU (High Performance Computing Cluster) experimentiert. Das Llama 3 basierte Modell „Sauerkraut 70B“ war daraufhin das erste Modell, das wir im November 2023 zur breiten Nutzung an der HU angeboten haben. Das Modell konnte sowohl über ein selbst entwickeltes User-Interface genutzt werden als auch per API für eigene Entwicklungen. Dieser Ansatz der freien Verfügbarkeit von LLMs – sowohl per Chat als auch für eigene Applikationen – hat sich seitdem sehr bewährt und wurde zum Standard für alle KI-Angebote der HU. Die zugrundeliegenden LLMs wurden seit dieser Zeit stetig weiterentwickelt und durch neue, leistungsfähigere Sprachmodelle ersetzt.

Der CMS hat die Einführung dieser Modelle durch das Kommunikationsformat „AI Teatime“ begleitet und führt dieses bis heute durch.

Hierbei werden individuelle Videokonferenzen für einzelne Nutzer:innengruppen organisiert, in denen die spezifischen Anforderungen und Hintergründe der anfragenden Abteilung oder Disziplin berücksichtigt werden. Die Termine verlaufen dadurch sehr unterschiedlich, und aus den Gesprächen ergeben sich immer wieder neue, konkrete Anwendungsszenarien sowie auch Anforderungen an den Ausbau der KI-Infrastruktur der HU.

KI-Leitfaden für die HU

datenschutzkonforme große Sprachmodelle für den Einsatz in Forschung, Lehre und Verwaltung (nur aus HU-Netz oder VPN)

HPC@HU – High Performance Computing Cluster für die Forschung

Aufbau eines JupyterHubs und Einbindung in die digitale Lehr- und Lernlandschaft der HU

KI-Tools (nur aus dem HU-Netz oder per VPN)

- Transkription von Video- und Audio-Dateien: https://ki-tools.hu-berlin.de/stt/

- Zusammenfassen von Dokumenten: https://ki-tools.hu-berlin.de/doc

- Informationen aus Bildern – maschinelles Sehen: https://ki-tools.hu-berlin.de/vision

Abb. 1: KI an der HU im Überblick: https://ki.cms.hu-berlin.de

Datenschutz und Richtlinien

Von Beginn der Aktivitäten an gab es Anfragen aus der Forschung, die Prompts und Ergebnisse aller LLMs an der HU zu speichern und für Forschende zugänglich zu machen. Gleichzeitig kamen von Datenschutz und Personalvertretung Impulse, die Vorteile der lokalen KI-Dienste möglichst umfassend zu nutzen. Wir haben uns daraufhin für ein Betriebsmodell entschieden, bei dem keine Daten der Anwender:innen protokolliert werden. Die Nutzung der technischen Infrastruktur wird dabei hinsichtlich Ressourcennutzung, Anfragenhäufigkeit und Energieverbrauch detailliert erfasst, um den weiteren Ausbau planen zu können – dies jedoch unter striktem Verzicht auf die Speicherung personenbezogener Daten.

Parallel zu den Datenschutzfragen wurde mit Unterstützung der Medienkommission und des IT-Boards ein „Leitfaden zum Einsatz von generativen KI-Werkzeugen in Forschung, Lehre und Verwaltung an

der Humboldt-Universität zu Berlin“ entwickelt und von der Universitätsleitung bestätigt. Dieser informiert sowohl über die Nutzungsmöglichkeiten der KI-Dienste an der HU als auch über den verantwortungsvollen Umgang mit externen KI-Tools. Der Leitfaden (https://hu.berlin/ki-policy) enthält zudem die „Empfehlungen zur Nutzung von KI in Studienleistungen und Prüfungen an der HU“ sowie Hinweise zur korrekten Zitierung KI-generierter Inhalte.

Basis der Auswahl von LLMs sind fortlaufende Tests neu veröffentlichter Modelle. Dabei wurde deutlich, dass sich die Modelle in der ersten Hälfte des Jahres 2024 noch sehr spezifisch entwickelt haben: Modelle mit Stärken im Coding-Bereich zeigten Schwächen in der Textarbeit. Die leistungsfähigsten LLMs waren oft nicht für die deutsche Sprache optimiert, während Modelle mit guten Deutschkenntnissen bei Coding oder komplexeren Aufgaben an ihre Grenzen stießen.

Vor diesem Hintergrund wurden verschiedene Modelle für spezifische Einsatzzwecke erprobt und bereitgestellt. Es kristallisierten sich drei Kernanforderungen heraus: Ein LLM mit guten Deutschfähigkeiten, eines mit Schwerpunkt auf Coding sowie ein starkes Modell für englischsprachige Anfragen. Zusätzlich zeigte sich der Bedarf an schnellen Sprachmodellen für RAG- (Retrieval Augmented Generation) und Agenten-Entwicklungen, auch wenn diese möglicherweise Kompromisse bei der Ergebnisqualität erfordern.

Ein Durchbruch gelang mit der Veröffentlichung des Modells Command-R-Plus – erstmals ein offenes LLM, das sich in Tests sowohl als sehr leistungsstark erwies als auch über ausgezeichnete Fähigkeiten im Bereich der deutschen Sprache und Übersetzungen in elf weitere Sprachen verfügte.

Die Wahl eines LLM wird stets von den konkreten Einsatzzwecken bestimmt. Deshalb orientiert sich die Auswahl für die breite Nutzung an der HU eng an den identifizierten Anwendungsszenarien. Mittlerweile setzen wir als Haupt-LLM (https://hu.berlin/llm1) ein Modell ein, das sich hervorragend für ein breites Spektrum von Aufgaben eignet – von der Textarbeit über die Lösung von Aufgaben bis hin zum Coding.

Aktuelle Funktionen und Tools

Aus den Gesprächen bei der AI Teatime entwickelten sich rasch direkt nutzbare Anwendungsszenarien für die Sprachmodelle. Die LLMs erwiesen sich als besonders effektiv für die Erzeugung von Social-Media-Posts aus längeren Texten, die Umwandlung in „Einfache Sprache“ sowie für Übersetzungen. Für solche Szenarien haben wir optimierte Prompts entwickelt, die unter https://ki.cms.hu-berlin.de/de/llms-in-der-anwendung zur Verfügung stehen. Weitere dort bereitgestellte Tools unterstützen bei der Überarbeitung von FAQ-Einträgen, der Erstellung von Stellenausschreibungen, der Generierung von Einladungsschreiben, dem Gendern von Texten sowie bei der Rechtschreibkontrolle und Überarbeitung von Formulierungen.

LLMs werden zunehmend auch direkt von Systemen genutzt, statt über Chat-Interfaces. Diese Anwendungen erfordern spezifische technische Funktionen wie „Function Calling“, strukturierte Ausgaben (z. B. in JSON) und größere Kontextlängen für umfangreiche Texte. Unser LLM3 (https://hu.berlin/llm3) erfüllt diese Anforderungen. Ein Beispiel ist die Integration lokaler LLMs für Übersetzungen in den Shared-Services-Catalogue der BUA, wo deutsche Formulareingaben automatisch ins Englische übertragen werden – ohne zusätzliche Kosten und komplexe Datenschutzbewertungen.

Weiterhin werden LLMs nicht mehr nur für die Unterstützung beim Coding durch das Chat-Interface eingesetzt, sondern können durch

Plugins wie „Continue“ auch direkt in die Entwicklungsumgebungen eingebunden werden. Dies unterstützen wir mit einer besonders schnellen und im Coding-Bereich auch sehr effektiven LLM.

Bereits seit 2023 setzt der CMS das KI-Modell „Whisper“ für die automatische Transkription und Untertitelung von Audio- und Videodateien ein. Seit Juli 2023 steht diese Funktion unter https://ki-tools.hu-berlin.de/stt/ allen HU-Angehörigen zur freien Nutzung zur Verfügung. Der Dienst ermöglicht das Hochladen von Dateien bis zu 4 GB und liefert die fertigen Transkriptionen und optional auch Übersetzungen per E-Mail in verschiedenen Formaten (TXT, VTT, SRT und TSV).

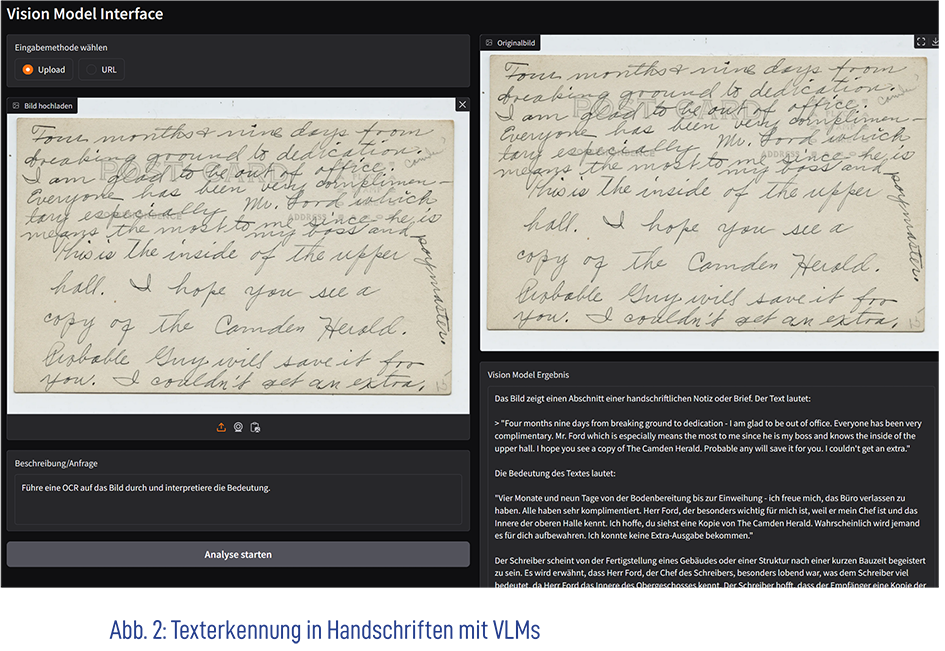

Seit November 2024 ergänzt ein Vision-Modell (VLM bzw. Multimodales Modell/LMM) das Angebot und steht unter https://ki-tools.hu-berlin.de/vision als Chat-Interface zur Verfügung. Dieses Modell ermöglicht vielfältige Bildanalysen: von der Texterkennung (Optical Character Re-cognition, kurz OCR) über die Identifizierung von Formeln und Bild-inhalten bis hin zur Umwandlung von Skizzen in Webseiten-Code oder Scans in TEI-Format. Das System kann auch Illustrationen automatisch beschreiben und für die Texteinbindung aufbereiten. Ein besonders praktischer Anwendungsfall ist die Analyse und Transkription von Vorlesungsmaterialien wie PowerPoint-Präsentationen und Skripten. Die Einsatzmöglichkeiten sind vielfältig – die Anwender:innen sind eingeladen, die Potenziale dieser Modelle für ihre spezifischen Anforderungen in Forschung, Lehre und Verwaltung zu erkunden.

Als Reaktion auf zahlreiche Nachfragen bieten wir seit November 2024 einen Dienst zur automatischen Zusammenfassung von PDF- und Word-Dokumenten an. Der Service ermöglicht das Hochladen und die inhaltliche Analyse von Dokumenten beliebiger Größe, wobei die Ausgabesprache unabhängig von der Originalsprache gewählt werden kann. Für die Ausgabe stehen zehn verschiedene Sprachen zur Verfügung.

Die Zusammenfassungen können in verschiedenen Modi erstellt werden:

„kurz“, „ausführlich“ oder „rein thematisch“ – wobei letzterer sich auf das behandelte Themengebiet konzentriert, ohne die Dokumentenstruktur zu berücksichtigen. Zusätzlich besteht die Möglichkeit, eine „kritische Reflexion“ anzufordern oder „Stichpunkte und Verweise“ aus dem Dokument extrahieren zu lassen. Der Dienst kann auch mit eigenen Prompts und zusätzlichen Anweisungen individuell angepasst werden.

Seit Dezember 2024 betreiben wir eine Testumgebung zur Erzeugung von Bildern aus Texten. Da dieser Dienst die Stabilität und Qualität unserer anderen Angebote noch nicht erreicht, werden die Tests fortgeführt. Das Tool ermöglicht die Erstellung von Grafiken und Symbolbildern und eignet sich besonders zur Ergänzung von Präsentationsmaterialien oder als Alternative zu Stock-Photo-Diensten.

Für erweiterte Nutzungsszenarien ist häufig die Verarbeitung großer Dokumentenmengen erforderlich, die den üblichen Kontext von LLMs deutlich übersteigen. Dies betrifft etwa virtuelle Assistenzsysteme für Vorlesungen, die Transkripte, PowerPoint-Dateien und Skripte einbinden sollen, oder die Integration umfangreicher Korpora für sprachliche Abfragen. Um diese Limitierung zu bewältigen, setzen wir auf RAG-Umgebungen.

An der HU wurden bereits verschiedene RAG-Umgebungen implementiert und getestet, mit gemischten Ergebnissen: Während virtuelle Vorlesungsassistenten durchweg positive Bewertungen erhielten und die Integration von Korpora für sprachliche Abfragen überwiegend erfolgreich verlief, konnten andere Systeme zur Verarbeitung großer Dokumentenmengen die Anforderungen nur teilweise erfüllen. Unser Ziel ist es, LLM-basierte RAG-Umgebungen zu entwickeln, die sich unkompliziert erstellen und flexibel nutzen lassen. Die Bereitstellung erfolgt dabei über APIs, um eine einfache Integration in bestehende Systeme wie Moodle oder Webseiten zu ermöglichen.

Zukunftsperspektiven und Entwicklungen

„KI-Agenten“ als Unterstützungstechnologie für komplexere Umgebungen gewinnen aktuell stark an Bedeutung. Der CMS untersucht Plattformen zur Modellierung von Agentensystemen in Verbindung mit RAG, die ebenfalls per API bereitgestellt werden. Die Entwicklung solcher KI-Agenten ist allerdings komplex – wir sind dabei auf Ihre konkreten Anwendungsszenarien und Ideen angewiesen, um praxisnahe Systeme zu entwickeln.

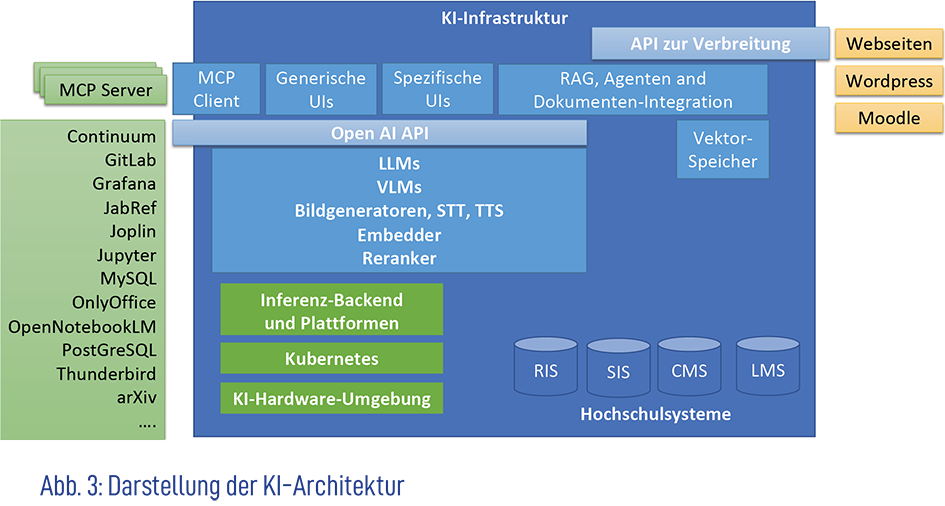

Unsere Erfahrungen mit RAG-Umgebungen und Agentensystemen bestätigen den grundlegenden Ansatz des CMS, KI-Dienste per API anzubieten. So wurde deutlich, dass neben Sprachmodellen weitere generative KI-Komponenten in die Infrastruktur integriert werden müssen. Im Verlauf des Jahres 2025 werden wir deshalb verschiedene Embedding-Modelle, die Medien für KI-Systeme codieren, sowie Reranker zur intelligenten Sortierung von Suchergebnissen über Schnittstellen bereitstellen. Diese Komponenten ermöglichen die Entwicklung flexiblerer eigener Anwendungen und eine noch effizientere Verarbeitung großer Datenbestände. Ihre Ideen und Wünsche sind uns dabei wichtig – sprechen Sie uns gerne an.

Die KI-Infrastruktur der Humboldt-Universität hat sich seit ihrer Einführung 2023 zu einem umfassenden Ökosystem entwickelt, das Forschung, Lehre und Verwaltung gleichermaßen unterstützt. Der Fokus auf lokale Bereitstellung, Datenschutz und flexible API-Nutzung hat sich als zukunftsweisend bestätigt. Ein besonderer Vorteil liegt in der datenschutzkonformen Nutzung: Anfragen und Daten können unkompliziert direkt verarbeitet werden, die bei anderen Anbietern jeweils einzeln geprüft werden müssten. Mit der Integration weiterer KI-Komponenten wie Embedding-Modellen und Rerankern wird die Infrastruktur auch künftige Anforderungen erfüllen können.

Der Erfolg dieser Entwicklung basiert maßgeblich auf dem kontinuierlichen Dialog mit der HU-Community und der daraus resultierenden bedarfsorientierten Weiterentwicklung.